刚刚在斯坦福商学院SIEPR经济峰会上提出“在未来的10年里,英伟达将会把深度学习的计算能力再提高100万倍。”豪言壮语的黄仁勋,凭借一颗B200又一次“沸腾”了整个AI行业。

在当地时间3月18日的演讲中,英伟达的黄仁勋发表了题为《见证AI的变革时刻》的主题演讲,介绍了英伟达在最新研发进展方面的成果。他围绕五大板块,分别是新的产业发展、Blackwell平台、创新软件NIMs、AI平台NEMO和AI工坊服务,以及仿真平台Omniverse和适用于自主移动机器人的Isaac Robotics平台展开了介绍。

英伟达“史上最成功的产品”

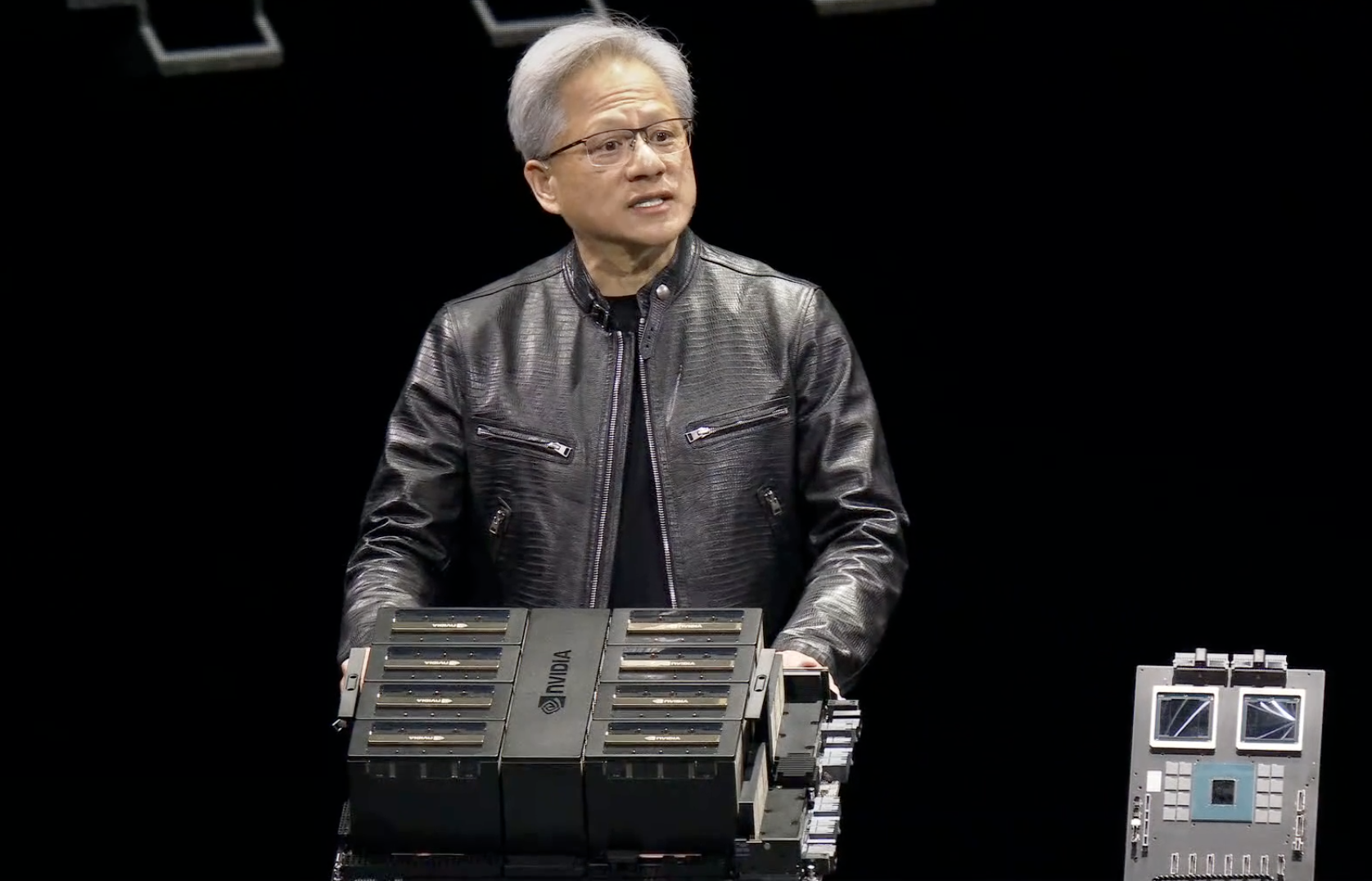

其中,最为炸场的,莫过于黄仁勋首次揭示了英伟达的最新一代AI芯片Blackwell GPU,即B200,这一GPU平台也是黄仁勋口中“英伟达史上最成功的产品”。

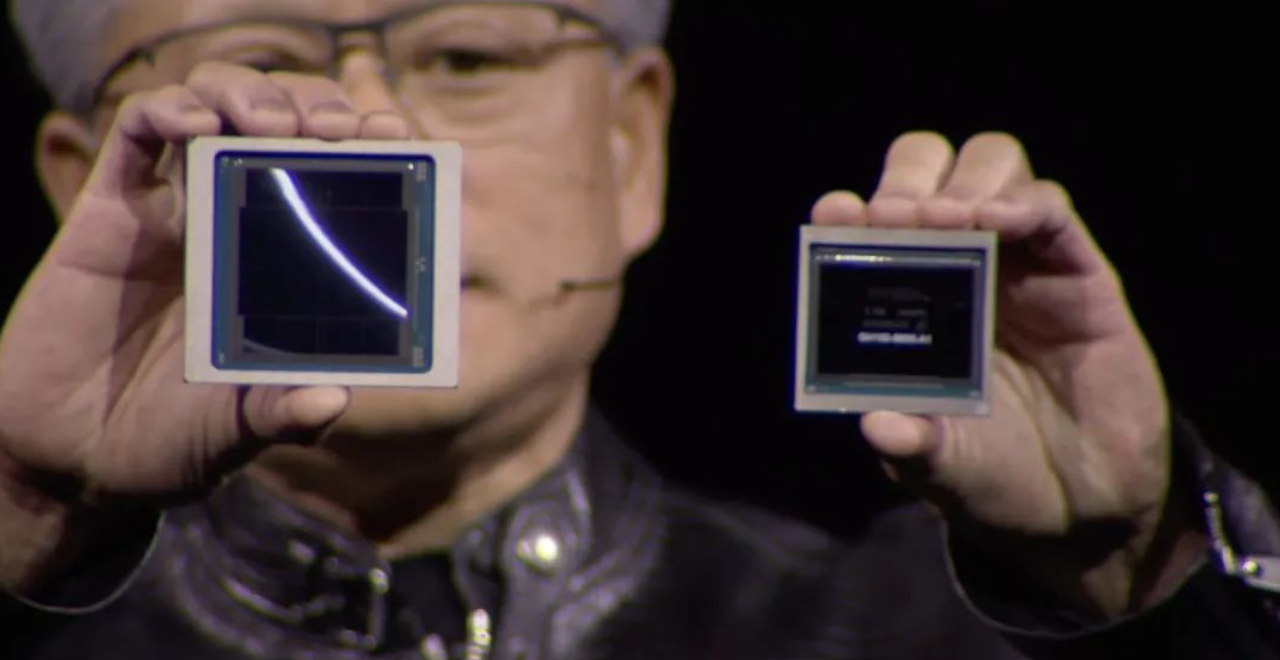

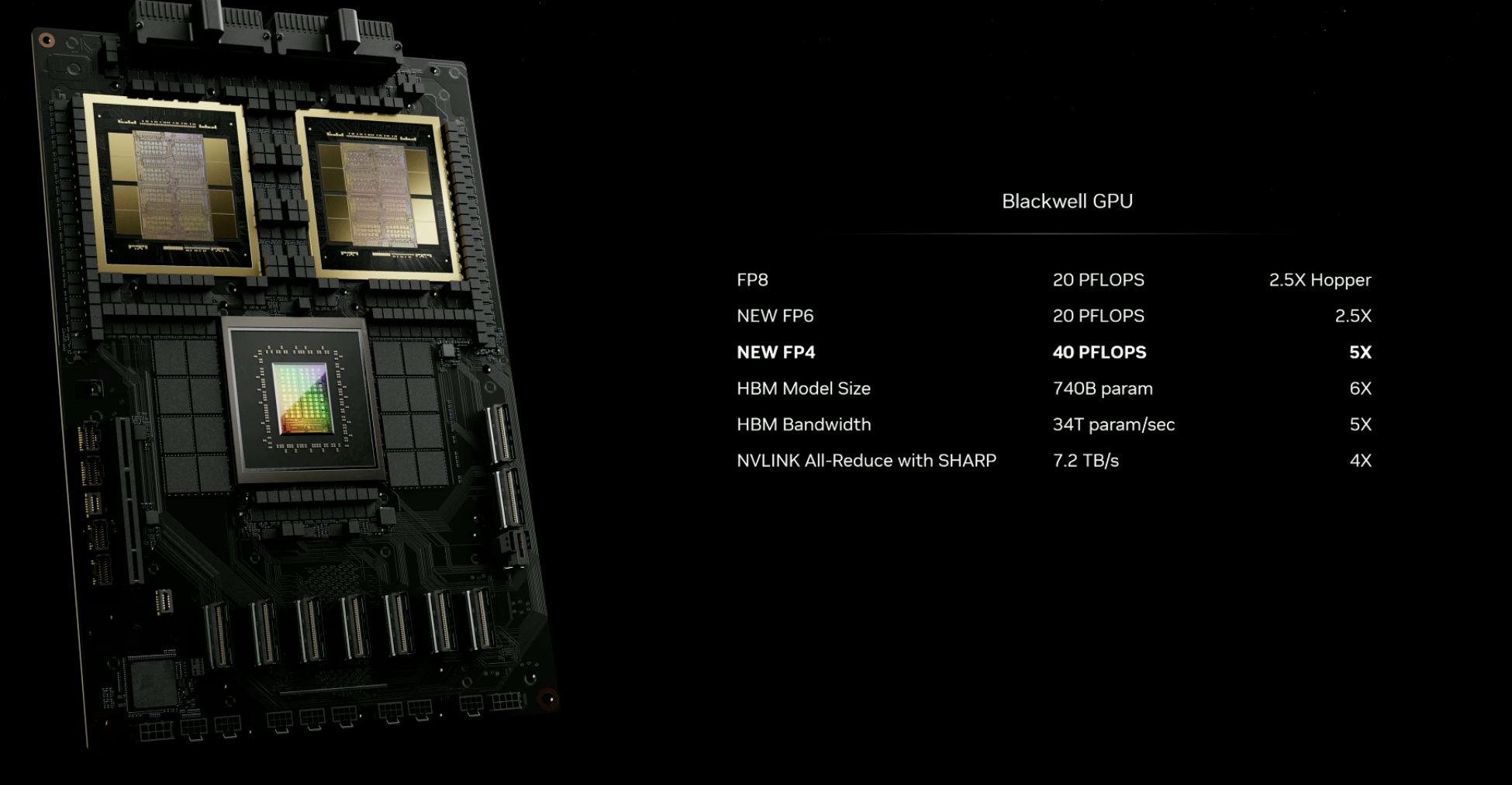

据介绍,Blackwell GPU以数学家David Harold Blackwell的名字命名,该芯片采用台积电的4纳米工艺,拥有2080亿个晶体管,同样沿用了英伟达此前推出的Hopper架构,可以支持多达10万亿个参数的AI模型。据介绍,B200能够提供高达20 PFlops的FP4八精度浮点运算能力,较之前的产品性能有了质的飞跃。此外,黄仁勋还展示了基于B200的GB200加速卡,带来了巨大的性能提升和效率提高。此外,Blackwell 架构还采用了第五代NVLink高速互联、第二代Transformer引擎等多方位全面升级。

不仅单块GPU性能大幅提升,两个B200 GPU与Grace CPU结合就成为GB200超级芯片,通过900GB/s的超低功耗NVLink芯片间互连技术连接在一起,成为一个Blackwell计算节点。

在NVLink Switch支持下,英伟达暴力地将72块B200连接在一起,最终成为“新一代计算单元”GB200 NVL72。一个像这样的“计算单元”机柜,FP8精度的训练算力就高达720PFlops,直逼H100时代一个DGX SuperPod超级计算机集群(1000 PFlops)。与相同数量的72个H100相比,GB200 NVL72对于大模型推理性能提升高达30倍,成本和能耗降低高达25倍。

英伟达还透露,这一全新的芯片将在2024年晚些时间上市。目前,亚马逊、戴尔、谷歌、Meta、微软、OpenAI、特斯拉都已经计划使用Blackwell GPU。

除了硬件创新,英伟达还在软件领域取得了新的进展。NIM微服务是其中的一项亮点,它可适用于优化英伟达生态系统中的20多个AI模型,为企业提供定制化的AI应用开发和部署服务。此外,黄仁勋还介绍了英伟达的仿真平台Omniverse和Isaac Robotics平台,展示了英伟达在机器人领域的前瞻性布局和创新成果。

AI行业的“新摩尔定律”

在大模型引领的人工智能的热潮之下,凭借着GPU的算力以及带宽领域的优势,以及自身的CUDA生态优势,不仅让英伟达成为AI领域最赚钱的企业之一,同时也让黄仁勋在AI时代有了更大的“野心”。在英伟达2023年财报中,截至9月数据中心的收入为150亿美元,到了2023年底,其收入同比增长了279%。

刚刚在斯坦福商学院SIEPR经济峰会上提出“在未来的10年里,英伟达将会把深度学习的计算能力再提高100万倍。”

如果将这一目标解构,便可以粗略得出英伟达每年要将算力提升为前一年的4倍。这意味着,如果英伟达的目标真正实现,这家公司将成为引导AI行业“新摩尔定律”发展的奠基者。

众所周知,“摩尔定律”是英特尔创始人之一戈登·摩尔的经验之谈,其核心内容为:集成电路上可以容纳的晶体管数目在大约每经过18个月到24个月便会增加一倍。而对于英伟达而言,“每12个月将AI算力提升4倍”的目标,相比摩尔定律,无疑显得更加乐观与激进。

要知道,此前8年时间的时间里,AI算力的增长也仅仅在以“千”为量级。

根据英伟达现场发布的公开资料,新一代AI芯片B200在处理支持人工智能的模型方面表现出了显著的性能提升。与之前的H100相比,B200在开发技术的过程(预训练阶段)以及技术运行过程(推理)中的速度都提高了数倍。

具体来说,以前训练一个拥有1.8万亿参数的模型需要8000个H100GPU和15兆瓦的功率。而如今,使用新的B200芯片,同样的模型只需要2000个GPU就可以完成训练,同时功耗仅为4兆瓦,相当于原先功耗的约四分之一。这意味着在相同的任务下,使用B200芯片进行训练不仅速度更快,而且能够显著降低能源消耗,提高效率。

可以说,从性能与能效表现的角度来看,英伟达新一代AI芯片B200确实的有了长足的进步。不过,大模型之家也注意到,尽管第五代NVLink Switch高速互联技术为每个GPU 提供了1.8TB/s双向吞吐量,确保多达576个GPU之间的无缝高速通信,同时大幅节约了能耗。

但面对4nm工艺制程即将达到极限,英伟达选择提升算力的方式非常的粗暴,通过堆砌运算单元规模,实现性能的大幅提升。这意味着,在大模型训练算力6个月翻一番的预期之下,想要实现算力的持续供给,需要不断更新迭代硬件设备,甚至不断扩建更大的算力集群。

这意味着,英伟达将核心发力点放在了“更大”与“更强”之上,通过不断探索AI算力的极限,在开辟加速计算领域的“新摩尔定律”的同时,收割头部AI企业对于算力增长的需求。

写在最后

在Blackwell芯片的背后,我们可以看到“新摩尔定律”并非遥不可及,但也要注意到尽管NVIDIA将可扩展的GPU架构与摩尔定律相结合,但硬件性能的提升现在更多依赖于芯片之间的互联。此外,硬件性能的提升并非像宣传中所说的那样夸张,而是通过不断提升数据精度实现的,从最初的高性能计算到现在的FP64、FP32、FP16、FP8以及FP4,这也预示着随着半导体行业逐渐逼近物理极限,大模型对于算力的提升也要寻找新的突破方式。

同时,GB200 NVL72的液冷机架以及“超级盒子”DGX SuperPOD的发布,也为大型模型公司提供了更便捷的“批发”选择,极高的性能背后,其不菲的价格也将进一步提振英伟达未来的营收预期。

但不可否认的是,英伟达此次发布的一系列设备,使得IT部门能够为各用户和工作负载提供出色的性能,成为AI数据中心基础设施的典范。在更强大算力的支撑之下,人工智能领域的新一轮突破也将指日可待。